06 Fév DATAIKU: Un outil pour faciliter la Data Science ?

Dataiku, data science, data analyse , data, data …

La data, c’est une montagne d’infos : soit tu l’exploites, soit tu te laisses dépasser. Bien utilisée, elle aide à décider plus vite et plus juste pour anticiper, piloter l’activité ou maîtriser les coûts.

Le vrai enjeu, ce n’est pas d’accumuler des données, mais d’en faire des outils concrets qui fonctionnent vraiment en production. Et surtout, de bien combiner IA et expertise métier : la machine calcule, l’humain tranche.

Le tout, évidemment, en respectant le cadre (RGPD, éthique, bon sens) pour que la data reste un levier, pas une contrainte.

DATAIKU, entreprise américaine, a décidé de mettre la data science au service des entreprises, pour que les prédictions et autres modèles statistiques ne soient plus réservés aux seuls chercheurs. L’outil permet d’aller plus vite, de rendre ces technologies accessibles à des profils non experts et de faire passer les projets data du labo à la réalité du terrain.

Data science : c’est quoi exactement ? Petit tour d’horizon

La data science, aussi appelée science de la donnée, ou statistiques pour les puristes, consiste à étudier les données afin d’en extraire des connaissances utiles et exploitables.

Pour extraire ces connaissances, la data science s’appuie principalement sur les mathématiques, en particulier les statistiques, combinées à l’informatique et, dans certains cas, à l’intelligence artificielle (machine learning).

L’objectif est de transformer de simples chiffres en informations actionnables afin d’éclairer et d’améliorer la prise de décision.

Pour simplifier, on distingue trois grands domaines en statistique :

Statistique descriptive :

Observer et résumer les données dont on dispose.

Exemple : calculer la moyenne des notes de français d’une classe de 6ᵉ.

Outils : moyenne, médiane, écart-type.

Statistique inférentielle

Partir d’un échantillon pour estimer une réalité plus large.

Exemple : estimer la taille moyenne des Français à partir d’un échantillon de 200 personnes.

Outils : tests d’hypothèse (t-test, chi²…), intervalles de confiance.

Modélisation statistique (IA / machine learning)

Construire des modèles pour expliquer ou prédire des phénomènes.

Exemple : prédire le prix d’une maison.

Outils : régression linéaire ou logistique, random forest.

Comment fait-on de la data science, et avec quoi ?

Pour faire de la data science, il faut avant tout les bons ingrédients : des données (qu’elles proviennent de fichiers, de bases de données ou d’API ), quelques outils pour les exploiter (R, Python, Excel, Dataiku…), ainsi qu’un minimum de logique et une certaine appétence pour les mathématiques.

Côté outils, deux grandes approches coexistent:

La première repose sur des outils orientés code, comme R, Python, SQL ou les notebooks. Ils sont généralement utilisés par des data scientists au profil très statistique, des chercheurs ou des développeurs, et offrent une grande liberté pour concevoir des analyses et des modèles sur mesure.

La seconde s’appuie sur des outils low-code ou no-code, tels que Dataiku, Alteryx, KNIME ou Power BI. Ces solutions sont particulièrement adaptées aux data analysts, aux utilisateurs métier ou aux chefs de projet et ingénieurs souhaitant se former à la data science sans entrer immédiatement dans la complexité du code.

Et si on voyait ce que ça donne avec Dataiku ?

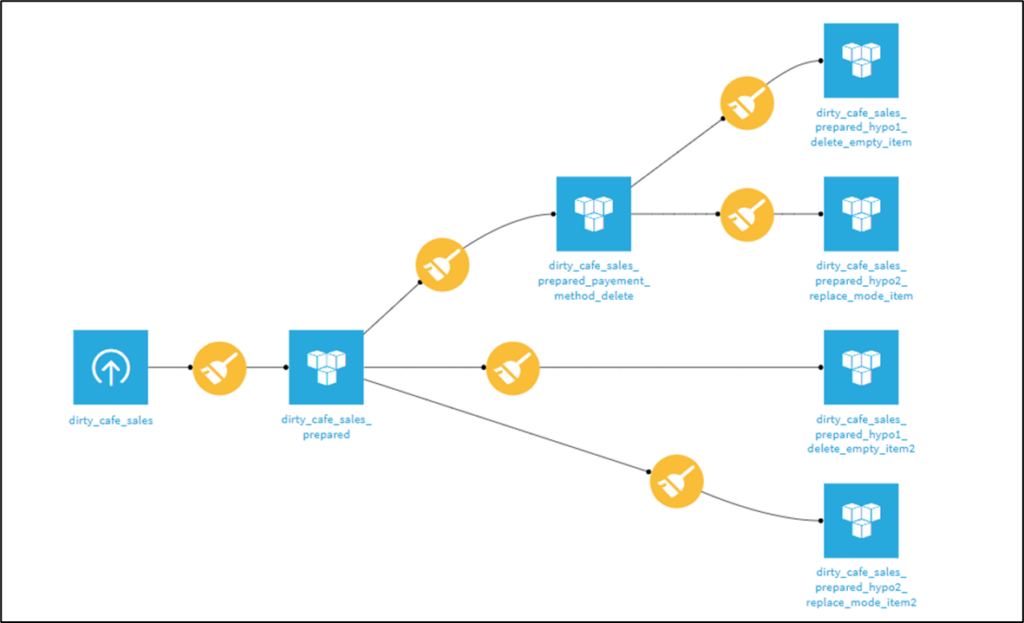

J’ai utilisé Dataiku pour couvrir les premières étapes d’un projet data, en me concentrant sur le nettoyage et la préparation des données ainsi que sur une analyse exploratoire simple. La navigation et l’exploration intuitives et les transformations très visuelles permettent de comprendre rapidement les données. L’outil est conçu pour limiter les erreurs et sécuriser les manipulations, tout en offrant la possibilité de créer plusieurs variantes d’un même dataset afin de tester différentes hypothèses.

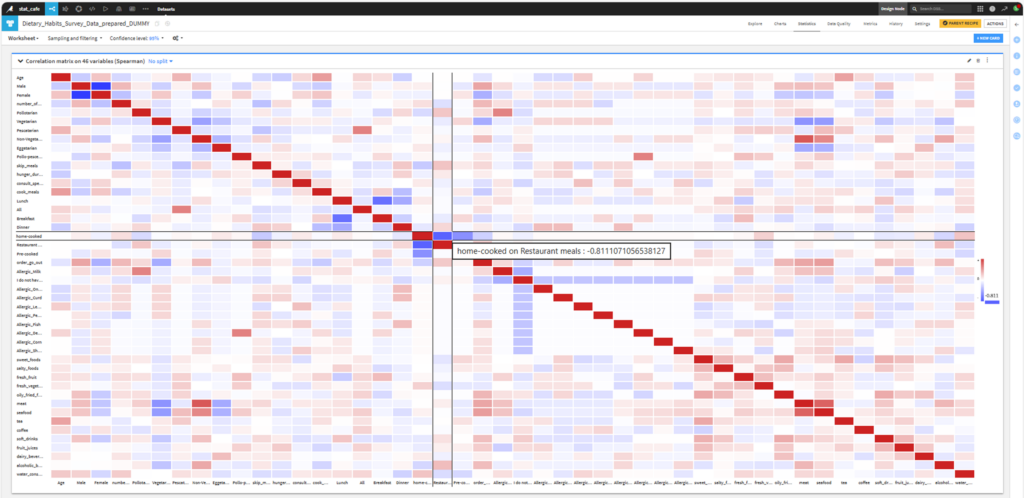

Pour approfondir l’analyse exploratoire, j’ai utilisé des méthodes plus avancées comme le t-SNE et la matrice de corrélation. Le t-SNE, utilisé pour représenter les données en 2D / 3D, n’étant pas disponible en recette visuelle, j’ai travaillé via un notebook Python directement intégré dans Dataiku, clair et bien renseigné, qui ne nécessitait que quelques adaptations pour être exploité avec le dataset utilisé.

La matrice de corrélation peut être réalisée directement via les recettes visuelles Dataiku. La conversion des variables en numérique se fait en quelques clics, et l’analyse obtenue est simple, rapide et fiable.

Si je sais utiliser DATAIKU, je suis un datascientist !!…?

IA et machine learning : une définition pragmatique

Encore une fois, pour simplifier, on peut parler d’intelligence artificielle dès lors qu’on utilise un modèle de machine learning, c’est-à-dire un algorithme entraîné sur des données. Lorsqu’un phénomène est décrit par un grand nombre de variables, il devient rapidement difficile pour l’humain de raisonner ou d’effectuer des calculs efficaces. La machine, elle, peut tester des milliers de combinaisons en très peu de temps et faire émerger des patterns que nous serions incapables d’identifier aussi rapidement. C’est, de façon simple, le principe du machine learning, et donc de ce que l’on appelle couramment l’IA « classique », dont l’objectif est de prédire, classifier, scorer ou anticiper.

Ces modèles sont aujourd’hui largement accessibles. Dans Dataiku, ils peuvent être utilisés directement via des composants prêts à l’emploi, comme les algorithmes de clustering ou modèle des k plus proches voisins, ou bien via des notebooks personnalisables pour aller plus loin dans l’expérimentation.

Tester le machine learning sur des données réelles

Pour tester concrètement le machine learning, j’ai utilisé un dataset d’environ un million de lignes, correspondant à autant d’individus ayant répondu à cinquante questions de personnalité. Chaque ligne représente un individu, chaque colonne une question, donc une variable. L’objectif de cette approche était de tenter de faire émerger des patterns de personnalité à partir de ces réponses.

Ces questions s’appuient sur les grands traits de personnalité décrits dans la littérature : ouverture, conscience, extraversion, agréabilité et névrosisme. La question posée au machine learning était alors la suivante : est-ce qu’il est possible de regrouper la personnalité d’un million d’individus en quatre, cinq ou six grands schémas ?

Avec Dataiku, il est très simple d’obtenir rapidement des résultats exploitables visuellement. Et avec l’aide d’un LLM, il devient même possible de construire un storytelling cohérent autour des schémas identifiés. De mon côté, j’ai obtenu une segmentation en quatre profils (cluster). J’ai ensuite appliqué le modèle sur de nouvelles données, récoltées auprès de mes collaborateurs BIIR, qui ont été classés dans ces différentes catégories.

Quand les résultats appellent à la prudence

Ce que l’analyse montre également, c’est l’importance du recul. Le modèle présente en effet un score de silhouette proche de zéro, ce qui signifie qu’il n’existe pas de séparation nette entre les groupes. Autrement dit, la structure détectée reste faible, même si les résultats peuvent sembler parlants à première vue.

Cela illustre un point essentiel : un outil peut produire des visualisations claires et des résultats interprétables, sans que ceux-ci soient nécessairement robustes d’un point de vue statistique. Dataiku facilite l’exploration et l’expérimentation, mais l’interprétation des résultats et l’esprit critique restent au cœur de toute démarche data.

La data, ce n’est pas de la magie, mais bien utilisée, ça peut faire gagner beaucoup de temps (et éviter pas mal d’erreurs). Souvent, tout commence par de la business intelligence : des données propres, des indicateurs clairs, des tableaux de bord qui répondent enfin aux vraies questions. Et quand ça devient intéressant, on peut passer à la data science pour aller un cran plus loin.

Si vous avez des données qui dorment et des questions qui s’accumulent, on peut vous aider à les réveiller. Simple, concret, et orienté métier.